Искусственный интеллект развивается слишком быстро. Что сделать, чтобы он не навредил человечеству? Искусственный интеллект окружил человека настолько плотно, что стал вопросом мирового значения.

Внедрение технологий искусственного интеллекта (ИИ) во все сферы жизни в ближайшие 20 лет, по прогнозу глобального института McKinsey, создаст новую реальность. Умная автоматизация может быть сопоставима с масштабами последней промышленной революции, что одновременно вызывает и воодушевление, и опасение за будущее человечества. Неудивительно, что исследователи по всему миру пытаются понять, как отрегулировать сферу искусственного интеллекта так, чтобы он не навредил людям. Возможно ли это Лента.ру разобралась, какие препятствия могут встретиться на пути регулирования ИИ.

Так завещал Стивен Хокинг

Стремительное развитие искусственного интеллекта будоражит умы исследователей по всему миру. В 2019 году Совет Европы учредил комитет экспертов по искусственному интеллекту (Ad hoc Committee on Artificial Intelligence — CAHAI). Решение создать подобный орган обусловлено крайне высокими темпами развития машинного обучения, в связи с чем возникла необходимость правового регулирования этих процессов. Члены организации считают, что отсутствие правовой подоплеки может грозить людям дискриминацией, посягательством на личную жизнь и манипулированием со стороны различных онлайн-платформ.

«Искусственный интеллект произведет революцию в нашей жизни. В таких областях, как медицина, связь и транспорт, открываются все новые возможности. Но последствия его продвижения для демократии, прав человека и верховенства закона все еще неясны. Как предупреждал ныне покойный Стивен Хокинг, риски нерегулируемого искусственного интеллекта беспрецедентны», — сказал генеральный секретарь Совета Европы Ягланд Тербьерн, объясняя необходимость создания спецгруппы по ИИ оценкой его угроз и возможностей для прав человека.

Уже в начале июля 2020 года на площадке CAHAI состоялась конференция, в которой участвовали более 250 представителей из 47 государств-членов Совета Европы. Кроме того, на мероприятии присутствовали делегаты из других стран, включая Ватикан, Израиль, Мексику, США и Японию.

«Обсуждают какую-то сущность, которой не существует»

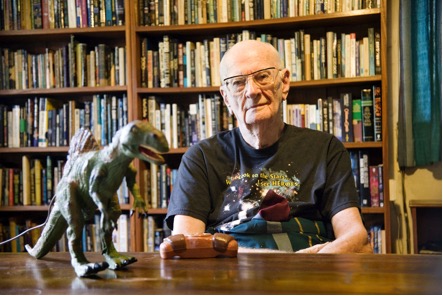

На недавнем заседании комитета Совета Европы вице-президент «Сколтеха» выделил одну из основных проблем развития искусственного интеллекта — необоснованное придание ИИ статуса субъектности. Ученый имеет в виду, что технологии сами по себе «этически нейтральны», поэтому не могут причинить реальное зло, в отличие от человека, который управляет интеллектуальными системами.

Мы надуваем мыльный пузырь важности ИИ и напрасно придаем этому набору технологий свойства субъекта. Во многом это делается журналистами, людьми без технического образования. Они обсуждают какую-то сущность, которой не существует. В массовом сознании формируется мем про ИИ, который наделяется чертами терминатора, с одной стороны, и чертами сверхсущества с благими намерениями — с другой. Все это сказки

По словам эксперта, при регулировании разработки и внедрения ИИ необходимо сохранять человекоцентричный подход во всех документах, а также избегать «очеловечивания». В противном случае появится асимметрия ответственности — как экономической, так и социальной. Другими словами, в любой непонятной ситуации человек сможет переложить вину на бездушный компьютер. Из-за этого создатель техники окажется невиновным и получит прибыль, а жертве придется разбираться с нанесенным ущербом самостоятельно.

Профессор Федоров считает такую ситуацию, когда риски ложатся на плечи конечных пользователей, недопустимой. Чтобы избежать подобных ситуаций, необходимо в первую очередь сосредоточиться на вопросах этики в сфере ИИ.

Что будет, когда роботы станут слишком умными, и нужно ли человечеству их бояться

«Проблема этических норм — первична. Выработав эти нормы, мы можем транслировать их на поведение в киберпространстве. Так как сейчас информационные технологии повсеместно проникают благодаря интернету (и ИИ не исключение), возникла потребность глобального документа, регулирующего этику технологий ИИ», — говорит российский ученый.

Этим уже занимаются, например, в Международной организации по стандартизации. Россияне участвуют в обсуждении в рамках технического комитета ТК-164, который разрабатывает технические стандарты для искусственного интеллекта на национальном, межгосударственном и международных уровнях. А также работает над первым полноценным руководством по этическим аспектам технологий автономных и интеллектуальных систем.

«Технические стандарты находятся в разработке. Над этим работают и в ООН. Например, в прошлом году был принят Пекинский консенсус по ИИ и образованию. Думаю, что со следующего года уже начнется разработка нормативов», — прогнозирует вице-президент «Сколтеха».

«Искусственного разума не существует»

И все-таки как должен регулироваться искусственный интеллект? В этом вопросе есть два важных аспекта, говорит Андрей Кулешов. Во-первых, правовая основа должна укреплять доверие к технологии и защищать интересы человека, общества и государства, а не наоборот. А во-вторых, — регулирование не должно мешать развитию отрасли, а с этим могут быть проблемы.

«Преждевременное регулирование в инновационной отрасли станет препятствием для инноваций, может привести к регуляторному арбитражу в погоне за инновациями и к доминированию крупных корпораций», — объясняет исследователь.

Он обращает внимание на то, что объектом регулирования является не столько система ИИ, сколько люди или организации, которые запустили эту систему. По сути, Кулешов поддерживает точку зрения Федорова, который призывает не наделять искусственный интеллект человеческими чертами.

«Самого по себе ИИ не существует. Существуют системы, которые демонстрируют свойства, так или иначе подобные естественному интеллекту… То есть мы регулируем технологии, не абстрактно-философский искусственный разум, которого пока, по моим сведениям, не существует», — так объясняет Кулешов.

Он считает, что логичнее всего для регулирования ИИ использовать риск-ориентированный подход — то есть регулировать те области, использование искусственного интеллекта в которых рискованно и может обернуться убытками. К примеру, работа чат-ботов в регулировании не нуждается, однако если ИИ ошибется в сфере медицины, последствия будут куда серьезнее.

Пять китов

Профессор частного права Политехнического университета Турина Александро Мартелеро считает, что системы с искусственным интеллектом должны создаваться так, чтобы служить человечеству, а при разработке и использовании таких систем обязаны соблюдаться права человека, требования по обеспечению демократии и верховенства права.

«Программы с искусственным интеллектом должны предусматривать возможность разумного человеческого контроля за их влиянием на отдельных людей и общество в целом», — заявил итальянский эксперт во время мероприятия CAHAI.

В свою очередь профессор биоэтики на кафедре здравоохранения и технологий Швейцарского федерального технологического института заявил, что при регулировании правовых актов для ИИ необходимо делать акцент на пяти этических принципах: прозрачности, справедливости, отсутствии злонамеренности, ответственности и защите частной жизни.

Фото: Fabrizio Bensch / Reuters

«Кажется, международное сообщество сходится во мнении о важности прозрачной, добросовестной, ответственной разработки и использовании этичного искусственного интеллекта, который также учитывает необходимость защиты частной жизни», — прокомментировал он свою позицию.

Кейтлин Мюллер, член группы Евросоюза высокого уровня по искусственному интеллекту, отметила, что разработка этических и правовых норм не должна восприниматься как препятствие для прогресса и инноваций. По ее словам, международно-правовые рамки регулирования ИИ нужны для того, чтобы не допустить безответственного развития технологий машинного обучения.

Понравилась статья? Поделитесь с друзьями!

При копировании материала ссылка на сайт Sauap.org обязательна!

Главное фото: https://www.cgi.com/sites/default/files/intelligence-artificielle_2.jpg